chainsawriot

Home | About | Archive又再教訓老闆

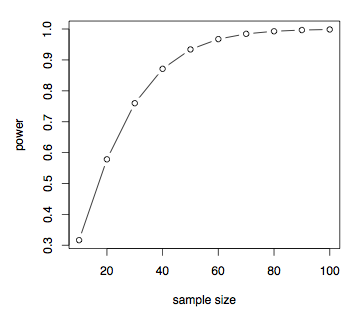

樣本數與統計檢驗力的關係,圖中所見每增加 20 個樣本、統計檢驗力增加愈來愈少。

老闆話要做一個一萬個 Subject 的 Study 。會找個義工,從 database 裡獲取資料。但問題是 database 是要人手 query 的。

他永遠覺得電腦萬能的,永遠不會算 resource implications ,由其是這個所謂研究是沒有任何 research grant 支持。

只有一個義工,這個義工不會跟你一年的,最多三個月,扣除星期六日,就當是 84 日吧。就當他真的神心到每天朝九晚五,中間一小時食飯,每天工作六小時。即是這個義工能提供 84 x 6 = 504 個 working hours 。

10000 個 subject 除以 504 個 working hours ,即是一個小時要 19.8 個 query ,還要加上數據輸入的時間。即是每三分鐘就要完成 query 公共 database a -> 根據 database a 的結果去 query 公共 database b -> 再從公共database b extract 約 50 個 variables -> 再輸入研究 database c 。

我想世上最 efficient 的 data entry clerk 都不能做得出這樣的效率。再者,這已經是假定,這位義工是在每天六個 working hours 不停工作,尿都唔屙。

他顯然沒有從一個三千人個 subject 的電話訪問研究,卻搞了兩、三年的故事中汲取教訓。就算資本豐腴如馬料水大學,我見到他們其中一個最大的研究,叫做 Mr OS/Ms OS ,也不會隨便將樣本數選為一萬,他們也只是將樣本數選為三千多人。他們也只是做一些醫生認為相當容易的問卷調查,但人家做這個研究也要一隊近十人的研究助理團隊。

Statistics 的發明,是我們只要一個細小的樣本,就能從此推演出群體的現像。樣本數增大,對於我這個自稱統計學人來說,其實分別不大。樣本數增加,如樣本為隨機抽樣的話,只能降低 sampling error ,亦即降低 Standard error ,但不會增加樣本的代表性( representativeness )繼而增加研究結果的代表性。我們是否值得為了降低 sampling error 而加重過多的資源消耗?這個是有遠見的研究學者會想到的問題。

與其增大樣本數來降低 sampling error ,我反建議是增加樣本的代表性。從一個有代表性的 sampling frame ,隨機抽出若干人數進行調查。這個「若干」,除了用正常的 sample size determination 方法計算之外,也要考慮到期刊的 reviewer 的心術不正。例如他們見到樣本數只有 2 digits ,介心會很大,很喜歡用樣本數不足來拒絕你,就算你的研究是找到正面的結果;見到 3 digits ,會開心多了。我又不認為由 3 digits 轉到 4 digits 甚至 5 digits , reviewer 的介心會作線性降低,之前講過人的觀感是 logarithmic 而不是 Linear ,去到某個位就會 plateau off 。當你的樣本數去到 4-5 個 digits ,人家就會找另一些把柄來打沉你。

我認為一個 realistic 的做法,是就算 Sample size determination 計出十幾、幾十個樣本已經可以,都增至百多個,確保這個樣本數的統計檢驗力( Statistical power )比你在 sample size determination 時的預計數值為高 ((但不會過份增加 Type I error rate )) ,同時亦可以滿足 reviewer 對 3 digits 的執迷。

最令我火滾的是,其實這個研究有很多人做過,其實再去 replicate 的意義不大,除非你能有些甚麼創新。由於太多人做過,有太多的數據可作 sample size determination ,之前幫他計過最保守的估計,也只需約 30 個樣本。那麼要增大三百多倍去一萬來托炮麼? ((我想我開始要收火,暫時要開始做 yes man once again 。否則我快會成為問題員工,在現行的合約制,我這類頂撞上司的合約制下屬,對比長工制的下屬,最有可能成為祭旗物。)) 這次是不涉及增加我的工作量的,但都是要出聲。因為實在太無理吧!

統計學巨匠圖克( John Tukey )曾經在批評金賽的性學研究報告時,說過這樣的一句話,我永遠都會用這句話作為參考:

A random selection of three people would have been better than a group of 300 chosen by Mr. Kinsey.

前事:教訓老闆

延伸閱讀:

Alone in the Fart: 網上調查不可信